실험 개요 및 배경

한국 정부는 해외 AI 모델에 대한 의존을 줄이고 ‘소버린 AI’(국가대표 AI) 프로젝트를 통해 국내 독자 인공지능을 개발 중이다 . 올해 8월 네이버클라우드, 업스테이지, SK텔레콤, 엔씨소프트(NC AI), LG AI연구원 등 5개 컨소시엄이 국가대표 AI 개발팀으로 선정되었으며, 2026년까지 글로벌 상위 10위권 진입을 목표로 하고 있다 . 이러한 배경에서, 서강대학교 수학과 김종락 교수 연구팀(CICAGO Lab)은 12월 12일 열린 ‘생성형 AI와 수학문제 해결 및 생성’ 워크숍에서 국내외 주요 대형언어모델(LLM) 10종의 수학 문제 해결 능력을 비교 평가한 결과를 발표하였다 . 이 평가를 통해 현재 공개된 국내 LLM들의 수학적 추론 역량 현주소를 진단하고 향후 개선 방향에 대한 시사점을 얻고자 한 것이다. 평가 실험은 서강대 수리과학 및 데이터사이언스 연구소(IMDS)와 AI 스타트업 딥파운틴(Deepfountain)이 공동 지원하였다.

연구팀은 국내 모델 5종과 해외 선도 모델 5종, 총 10개 LLM을 대상으로 동일한 수학 문제 세트를 풀도록 했다 . 문제 세트는 대한민국 대학수학능력시험(수능) 및 대학 논술 기출 등 고등교육 수준의 문제들로 구성되었다. 구체적으로, 수능 수학 공통과목, 확률과 통계, 미적분, 기하 영역에서 가장 어려운 문항을 각 5문제씩 선별해 20문항을 준비했고, 여기에 국내 10개 대학의 수리논술 기출 10문항, 인도 대학입시 10문항, 일본 도쿄대 공대 대학원 입시 수학 10문항을 추가하여 총 50문항을 마련했다 . 모든 문제는 인간 수험자로 치면 상당한 난이도의 문제들로, 국내 모델들에 대해 엄격한 평가가 이루어지도록 설계되었다.

평가 대상 AI 모델

국내 모델 5종: 국가대표 AI 프로젝트에 참여하거나 한국을 대표하는 LLM들로, 업스테이지의 「솔라 프로-2」, LG AI연구원의 「엑사원 4.0.1」, 네이버의 「하이퍼클로바 X-007」 (HyperCLOVA X 계열), SK텔레콤의 「A.X 4.0 (72B)」, 그리고 엔씨소프트가 자체 경량화한 「라마-바르코 8B 인스트럭트」가 실험에 사용되었다 . 이들 모델은 모두 평가 시점에 공개된 최신 버전으로 참여했으며, 일부는 수십억~수백억 매개변수 규모의 대형 모델이고 (예: A.X 4.0은 720억개 파라미터), 라마-바르코 8B처럼 비교적 경량 모델도 포함되었다.

해외 모델 5종: 오픈AI의 차세대 GPT 계열 「GPT-5.1」, 구글의 최신 미공개 모델 프리뷰 「Gemini 3 Pro (제미나이 3 프로 프리뷰)」, 앤스로픽(Anthropic)의 「Claude Opus 4.5 (클로드 오퍼스 4.5)」, 일론 머스크가 이끄는 xAI의 「Grok 4.1 Fast (그록 4.1 패스트)」, 그리고 칭화대 출신 연구진의 스타트업 딥시크(DeepSeek)가 개발한 「DeepSeek V3.2」가 비교 대상 해외 LLM으로 선정되었다 . 이들 모두 현재 글로벌 최첨단 수준의 생성형 AI로 평가되는 모델들로, 국내 모델들과의 격차를 가늠하는 기준점 역할을 한다.

1차 평가: 50문항 수학 문제 풀이 결과

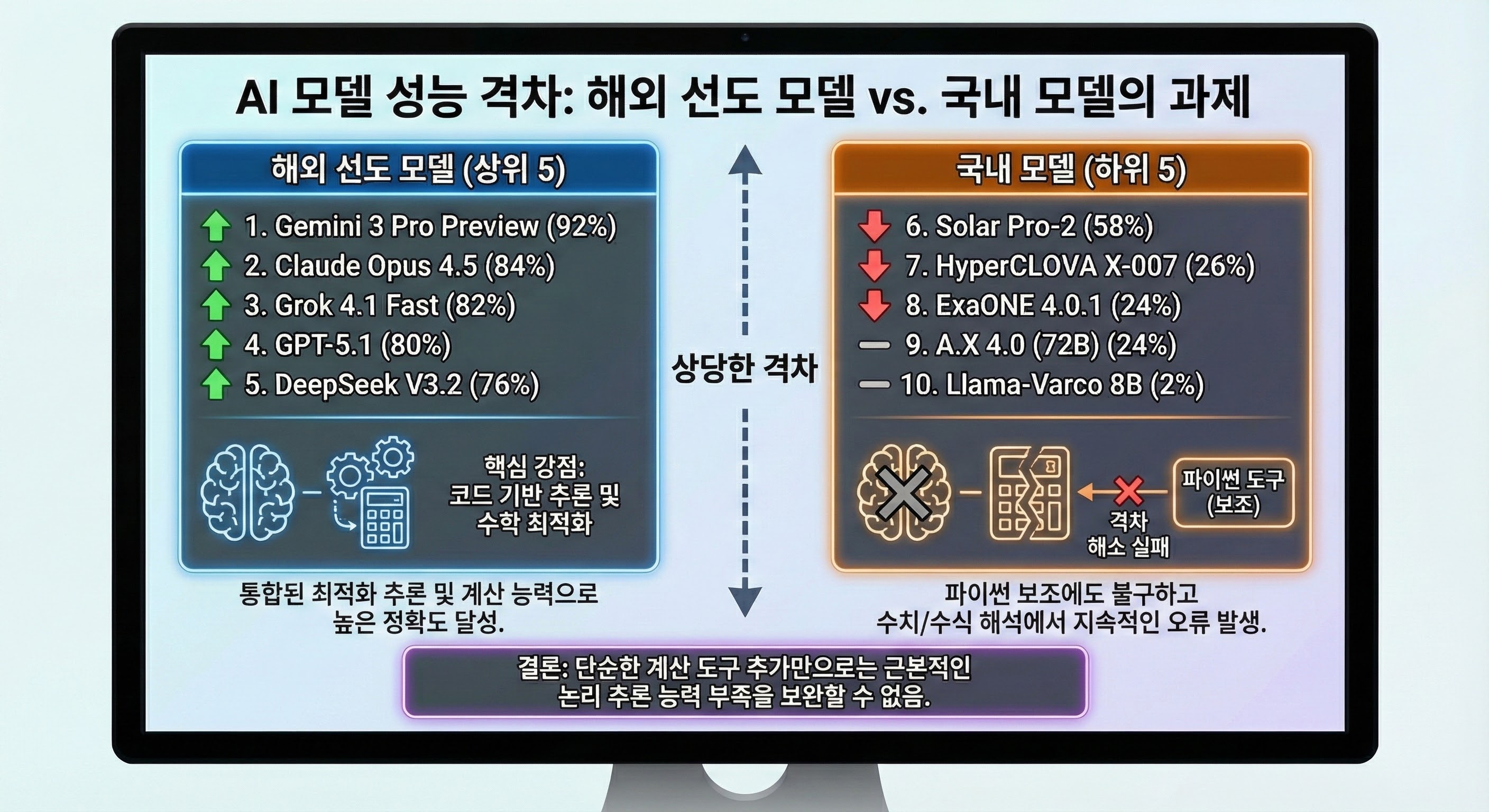

연구팀은 준비한 50개의 수학 문제를 각 모델에 제시하여 한 번씩 풀이하게 했다. 그 결과, 해외 모델들의 평균 성적은 80점대, 국내 모델들은 20~50점대로 크게 벌어졌다 . 해외 모델들은 76%~92%**의 높은 정답률(percentage of correct answers)을 기록한 반면, 국내 모델들은 2%~58%에 그쳤다  . 아래 그림은 모든 모델의 정답률을 보여준다.

50문제 평가에서 국내외 AI 모델들의 정답률 비교 (출처: 서강대 연구팀)

가장 우수한 성능을 낸 모델은 구글의 차세대 모델인 Gemini 3 Pro로, 92%**에 달하는 정답률로 1위를 차지했다 . 이어서 앤스로픽 Claude Opus 4.5가 84%로 2위, xAI Grok 4.1 Fast가 82%로 3위를 기록했다. OpenAI의 GPT-5.1은 80%로 4위에 그쳤으며, 딥시크 DeepSeek V3.2는 76%로 5위를 차지했다 . 일반적으로 최상위 성능으로 알려진 GPT-5 시리즈가 이 테스트에서는 4위로 밀려난 점도 흥미롭다 .

반면 국내 모델들은 상당히 저조한 결과를 보였다. 업스테이지 솔라 프로-2만이 58%의 정답률로 그나마 선전하여 국내 1위(전체 6위)에 올랐으나 , 나머지 모델들은 모두 30% 이하의 정답률을 보이며 사실상 대부분 낙제 수준이었다 . 네이버 HyperCLOVA X-007은 26%, LG ExaOne 4.0.1과 SKT A.X 4.0은 각각 24%, NCSoft Llama-Barco 8B 모델은 겨우 2%의 정답률을 기록하여 최하위를 면치 못했다 . 특히 라마-바르코 모델은 50문제 중 1문제만 정답을 맞히는 데 그쳐 (2점 획득), 수리 논술형 문제에서 현 수준의 작은 LLM이 얼마나 어려움을 겪는지 단적으로 보여주었다.

이 50문항 테스트의 모델별 순위를 정리하면 다음과 같다.

2차 평가: 고난도 EntropyMath 문제 결과

1차 평가에서 국내 모델들의 성능이 전반적으로 낮게 나오고, 특히 세부적으로 하이퍼클로바 X, 엑사원, A.X 4.0 세 모델이 모두 20%대 중반으로 비슷한 수준을 보여 구분이 어려웠다 . 이에 연구팀은 국내 모델들의 미세한 성능 차이를 보다 정밀하게 비교하기 위해, 자체 제작한 고난도 수학 문제 세트인 엔트로피매스 (EntropyMath)를 활용한 추가 실험을 진행했다 . 엔트로피매스는 난이도를 대학 학부 수준부터 교수 논문 연구 수준까지 세분화한 100문항으로 구성된 문제은행으로, 실제 국제 수학 올림피아드 출신 교수진과 분야 전공 교수들의 검수를 거쳐 퀄리티를 확보한 데이터셋이다 . 연구팀은 이 중 10문항을 선별하여 앞서 동일한 10개 모델들에게 풀이를 시도하도록 했다 .

그 결과, 어려운 문제들로 구성된 이 추가 평가에서도 해외 모델들은 82.8%~90%의 높은 정답률을 유지하여 실력을 입증했다 . 반면 국내 모델들은 7.1%~53.3%로 여전히 저조했는데, 그나마 업스테이지 솔라 프로-2가 53.3%로 가장 높았고 나머지는 40% 이하에 머물렀다 . 즉 해외 모델들은 문제 난이도가 올라가도 상당수 정답을 맞힌 반면, 국내 모델 상당수는 10문제 중 한두 문제 맞히는 수준에 그친 것이다.

특히 연구팀은 동일 문제에 대해 최대 3회까지 답안을 시도하게 한 뒤 한 번이라도 맞히면 통과로 인정하는 기준(Pass@3 개념)을 적용하여 재평가도 해보았다 . 이 완화된 조건에서는 해외 모델 중 Grok 4.1이 100% 만점을 기록했고, 나머지 해외 모델들도 90%로 거의 모든 문제를 결국 맞히는 높은 해결력을 보였다 . 그러나 국내 모델들은 반복 시도 기회를 줘도 향상 폭이 크지 않아, 솔라 프로-2가 70%, 엑사원이 60%, 하이퍼클로바 X가 40%, A.X 4.0이 30%, 라마-바르코 8B가 20%에 그쳤다 . 다시 말해 해외 모델들은 답을 모르는 문제도 몇 번의 시도 끝에 대부분 풀어냈지만, 국내 모델들은 여러 번 시도해도 맞히지 못하는 문제가 많았다는 뜻이다.

고난도 엔트로피매스 10문항에 대한 국내외 모델들의 정답률 및 PASS@3 비교 (출처: 서강대 연구팀)

추가 실험까지 종합하면, 해외 최첨단 LLM들은 수학적 추론과 문제 해결에 있어 현존 국내 모델들을 월등히 앞서 있음이 다시 한 번 확인되었다 . 국내 모델 중에서는 솔라 프로-2가 일관되게 가장 우수했지만(1차 58%, 2차 53%), 그 격차조차 해외 모델들과는 상당히 크다. 예컨대 솔라 프로-2의 엔트로피매스 점수 53%는 해외 모델들에 비하면 30%p 이상 낮은 수준이며, 나머지 국내 모델들은 더 말할 것도 없이 성능 차이가 벌어졌다.

평가 분석 및 향후 계획

김종락 교수는 이번 결과에 대해 현재 공개된 모델 기준으로 해외 선도 모델과의 AI 기술력 격차가 분명히 존재한다고 평가했다 . 이번에 테스트에 사용된 국내 5개 모델은 어디까지나 각 사(社)에서 이미 공개한 기존 버전일 뿐, 아직 개발 중인 차세대 국가대표 AI 모델들은 포함되지 않았다. 정부 지원 하에 각 컨소시엄이 개발 중인 신규 모델(예: HyperCLOVA X의 차기 모델, ExaOne 차기 버전 등)이 공개되면, 연구팀은 동일한 문제 세트로 성능을 다시 측정해볼 계획이라고 밝혔다 . 이를 통해 국내 AI 기술의 향상 추이를 객관적으로 추적할 수 있을 것으로 기대된다.

이번 실험은 국내 AI 업계에 뼈아픈 현실 확인과 도전 과제를 제시해 주었다. 해외 모델들과의 격차를 해소하기 위해서는 단순히 외부 툴(예: 파이썬 활용) 지원 능력을 붙이는 것만으로는 부족하며, 모델 자체의 근본적인 추론 능력 강화가 최우선 과제가 될 것이라는 지적이 나온다 . 특히 수학 문제 풀이와 같은 복잡한 논리·추론 영역에서의 역량은 거대언어모델의 언어 처리 능력을 넘어서는 도전으로, 향후 국내 LLM이 글로벌 상위권에 진입하려면 이러한 기초 기술 혁신이 시급하다 . 다만 이번 평가 결과가 공개됨으로써 강점과 약점이 명확해졌으므로, 이를 바탕으로 모델 개선을 지속해나간다면 격차를 좁힐 여지는 충분하다는 평가도 있다.

김종락 교수 연구팀은 이미 EntropyMath 기반의 수학 평가 리더보드를 온라인에 공개하여 국내외 누구나 모델 성능을 객관적으로 비교할 수 있도록 했다 . 이 리더보드는 향후 국제적인 평가 수준으로 확대해 나갈 계획이며, 문제 생성 알고리즘과 데이터 수집 파이프라인을 개선하여 수학뿐 아니라 과학, 제조, 문화 등 다양한 도메인에 대해서도 어려운 문제 데이터를 생성, 공개함으로써 도메인 특화 AI 성능 향상에 기여하겠다고 밝혔다 . 이러한 공개 평가와 데이터셋 축적을 통해 국내 LLM들이 꾸준히 발전하고, 장기적으로는 AI 주권 확보 목표를 이뤄나가길 기대해본다.

Sources: 평가 실험 결과 – MS투데이 , 동아사이언스   , 디지털포커스   , 연합뉴스  .

'IT & Tech 정보' 카테고리의 다른 글

| 한국삭도공업 종합 정보 보고서 (0) | 2025.12.19 |

|---|---|

| Sergey Brin의 AI 전략 실패 인정과 구글의 혁신 딜레마 분석, 제미나이 부활 (0) | 2025.12.19 |

| Surge AI: 비즈니스 전략, 조직 문화, 철학적 접근 심층 분석 (0) | 2025.12.11 |

| LatentMAS 기반 블랙박스 AI 에이전트 간 협업과 자가강화 가능성 (0) | 2025.12.07 |

| LatentMAS: Enabling Latent-Space Multi-Agent Collaboration (0) | 2025.12.07 |